深扒 NSFW Prompt 市场,这可能是 AI 最早跑通“付费意愿”的地方之一

深扒 NSFW Prompt 市场,这可能是 AI 最早跑通“付费意愿”的地方之一比如说,最近有一个叫做 Unlucid.ai 的视频生成网站流量很好,排名窜的很快,在这个网站主页里,你能看到非常「像片儿」的 AI 生成视频:有人反复试错,研究哪些描述可以通过,哪些词语组合更容易出结果,怎样的写法既不触发拦截,又能让画面往“成人内容”的方向靠近。

比如说,最近有一个叫做 Unlucid.ai 的视频生成网站流量很好,排名窜的很快,在这个网站主页里,你能看到非常「像片儿」的 AI 生成视频:有人反复试错,研究哪些描述可以通过,哪些词语组合更容易出结果,怎样的写法既不触发拦截,又能让画面往“成人内容”的方向靠近。

最初只是我写了一个特别好玩的 prompt,那个 prompt 是一个代入修仙世界的文字游戏,没想到这个 prompt 会成为所有故事的起点。后来我们把 prompt 包了一下,上了个简单的网页,实际上开发1周,形态是chatbox,纯文本+流式输出,有选项、死亡状态,非常简单的一波流的小玩具,但是也收到了很多正向反馈。

2025 年,AI 视频又把桌子掀了。手切金属、小猫做饭,甚至是那个火遍全网的「奥特曼宇宙」,对 AI 来说不过是几句 Prompt 的功夫。

十月,《纽约时报》发表了题为《The A.I. Prompt That Could End the World》(《那个可能终结世界的 AI 提示词》)的文章。作者 Stephen Witt 采访了多位业内人士:有 AI 先驱,图灵奖获奖者 Yoshua Bengio;以越狱测试著称的 Leonard Tang;以及专门研究模型欺骗的 Marius Hobbhahn。

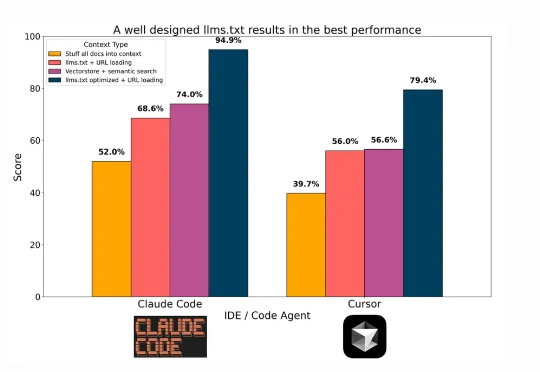

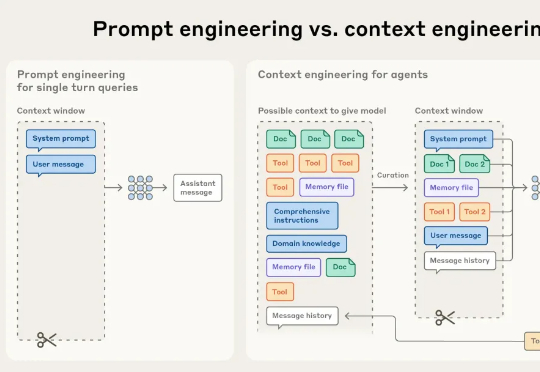

近日刚好得了空闲,在研读 Anthropic 官方技术博客和一些相关论文,主题是「Agent 与 Context 工程」。2025 年 6 月以来,原名为「Prompt Engineering」的提示词工程,在 AI Agent 概念日趋火热的应用潮中,

在技术飞速更新迭代的今天,每隔一段时间就会出现「XX 已死」的论调。「搜索已死」、「Prompt 已死」的余音未散,如今矛头又直指 RAG。

![苹果盯上Prompt AI, 不是买产品,是要伯克利团队的[视觉大脑]](https://www.aitntnews.com/pictures/2025/10/15/ca7bf835-a97f-11f0-88f9-fa163e47d677.jpg)

根据外媒 CNBC 消息,苹果公司正和计算机视觉领域的初创企业 Prompt AI,推进收购事宜的 “最后阶段谈判”。

库克和马斯克都盯上的CV公司!打开Prompt AI官网,上面介绍了这家公司的定位:一家专注于消费应用视觉智能的AI公司。这家总部位于旧金山的初创公司,其核心团队非常UC伯克利范儿:

Hi,返工早上好。 我是洛小山,和你聊聊 AI 行业思考。 AI Agent 应用的竞争逻辑,正在发生根本性变化。 当许多团队还在死磕提示词优化(PE 工程)时,一些优秀团队开始重心转向了上下文工程

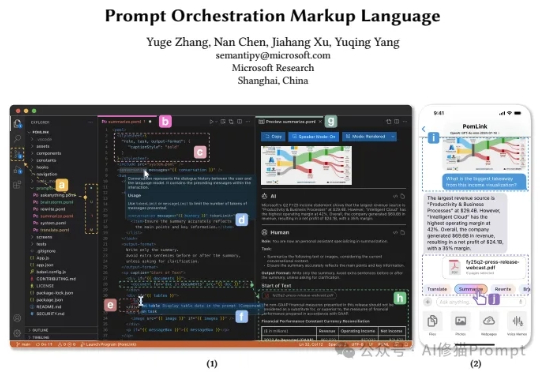

最近来自微软的研究者们带来了一个全新的思路,他们开源发布了POML(Prompt Orchestration Markup Language),它的的解决方案它的核心思想非常直接:为什么我们不能像开发网页一样,用工程化的思维来构建和管理我们的Prompt呢?这个编排语言很类似IBM的PDL